Машинное обучение

Важно выбирать подходящую метрику в соответствии с целями анализа и спецификой данных, чтобы получить объективную оценку качества модели регрессии и прогнозирования.

При выборе подходящей метрики для оценки качества модели регрессии и прогнозирования следует учитывать следующие факторы:

1. Цель анализа: Определите, какую информацию вы хотите получить из модели и какие вопросы вы хотите на них ответить. Например, если вам важно измерить точность предсказания, то среднеквадратичная ошибка (MSE) или корень из среднеквадратичной ошибки (RMSE) могут быть подходящими метриками. Если ваша цель заключается в понимании объясняющей способности модели, то коэффициент детерминации (R-squared) может быть полезной метрикой.

2. Специфика данных: Рассмотрите особенности ваших данных, такие как наличие выбросов, несбалансированность классов или другие аномалии. Некоторые метрики, такие как среднеквадратичная ошибка (MSE), могут быть чувствительны к выбросам, в то время как средняя абсолютная ошибка (MAE) более устойчива к ним. Также учтите, что некоторые метрики могут быть предназначены для специфических типов данных или задач, например, метрики оценки точности классификации.

3. Бизнес-контекст: Изучите требования вашего бизнеса и применение модели. Какие критерии важны для вашей организации? Например, если вы работаете в области финансов, то точность предсказаний может быть особенно важной. Если вы прогнозируете спрос на товары, то средняя абсолютная ошибка (MAE) может быть полезной для измерения ошибки в денежных единицах.

4. Сравнение моделей: Если у вас есть несколько моделей, которые вы хотите сравнить, убедитесь, что выбранная метрика позволяет справедливо оценить их производительность. Некоторые метрики могут быть более чувствительны к определенным типам моделей или данным.

В идеале, выбор метрики должен быть основан на комбинации этих факторов и отражать конкретные цели и требования вашей задачи. Важно также понимать интерпретацию выбранной метрики и уметь объяснить ее значение заказчикам.

Регрессия и прогнозирование играют важную роль в принятии решений в бизнесе. Они позволяют предсказывать и анализировать будущие значения переменных на основе имеющихся данных. Это помогает бизнесу планировать и оптимизировать свою деятельность, принимать обоснованные решения и достигать своих целей.

2.4. Рекомендательные системыРекомендательные системы являются важным инструментом в современном бизнесе, позволяющим предлагать пользователям персонализированные рекомендации товаров, услуг, контента и других элементов. Они основаны на алгоритмах машинного обучения, которые анализируют данные о предпочтениях и поведении пользователей для предсказания их предпочтений и предлагают соответствующие рекомендации.

Одной из основных целей рекомендательных систем является улучшение удовлетворенности пользователей и повышение конверсии. Путем предоставления релевантных и интересных рекомендаций, системы могут помочь пользователям находить нужные товары или контент, сэкономив их время и упростив процесс выбора. Также рекомендации способствуют удержанию пользователей и повторным покупкам, что в свою очередь может привести к увеличению выручки и прибыли компании.

Рекомендательные системы могут быть применены в различных отраслях, включая электронную коммерцию, медиа, социальные сети и другие. В электронной коммерции, например, они могут предлагать рекомендации товаров, основанные на истории покупок или просмотрах пользователей, а также использовать коллаборативную фильтрацию для нахождения схожих пользователей и предлагать им рекомендации, основанные на предпочтениях похожих пользователей.

Коллаборативная фильтрация

Одним из наиболее распространенных алгоритмов, используемых в рекомендательных системах, является коллаборативная фильтрация. Этот метод основан на предположении, что если два пользователя проявили схожие предпочтения в прошлом, то они будут иметь схожие предпочтения и в будущем. Коллаборативная фильтрация использует матрицу оценок пользователей (например, оценки фильмов или товаров) для нахождения схожих пользователей или схожих товаров и рекомендует пользователю те элементы, которые оценили похожие пользователи.

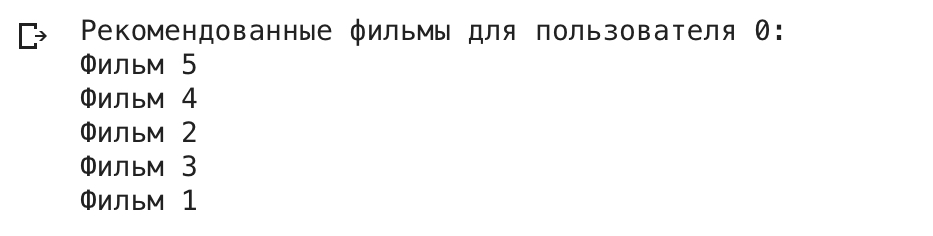

Пример программы, реализующей коллаборативную фильтрацию для рекомендаций фильмов:

```python

import numpy as np

# Пример матрицы оценок пользователей

ratings = np.array([

[5, 4, 0, 0, 0, 0],

[0, 0, 4, 0, 5, 0],

[0, 0, 0, 2, 4, 5],

[4, 0, 0, 0, 0, 4]

])

# Вычисление схожести пользователей на основе корреляции Пирсона

def compute_similarity(user1, user2):

mask = np.logical_and(user1 != 0, user2 != 0)

if np.sum(mask) == 0:

return 0

return np.corrcoef(user1[mask], user2[mask])[0, 1]

# Функция рекомендации фильмов для пользователя

def recommend_movies(user_id, ratings, num_recommendations=5):

num_users, num_movies = ratings.shape

# Вычисление схожести пользователя с остальными пользователями

similarities = []

for i in range(num_users):

if i != user_id:

similarity = compute_similarity(ratings[user_id], ratings[i])

similarities.append((i, similarity))

similarities.sort(key=lambda x: x[1], reverse=True)

# Выбор топ-N наиболее похожих пользователей

top_similar_users = [similarity[0] for similarity in similarities[:num_recommendations]]

# Получение рекомендаций на основе оценок похожих пользователей

recommendations = np.zeros(num_movies)

for user in top_similar_users:

recommendations += ratings[user]

recommendations = np.where(ratings[user_id] == 0, recommendations, 0)

top_movies = np.argsort(recommendations)[::-1][:num_recommendations]

return top_movies

# Пример использования

user_id = 0

recommended_movies = recommend_movies(user_id, ratings)

print(f"Рекомендованные фильмы для пользователя {user_id}:")

for movie_id in recommended_movies:

print(f"Фильм {movie_id}")

```

В данном примере используется матрица оценок пользователей `ratings`, где каждая строка соответствует пользователю, а каждый столбец соответствует фильму. Оценки фильмов могут принимать значения от 0 до 5, где 0 обозначает отсутствие оценки.

Функция `compute_similarity` вычисляет схожесть пользователей на основе корреляции Пирсона. Она сравнивает оценки двух пользователей, игнорируя нулевые значения, и вычисляет коэффициент корреляции.

Функция `recommend_movies` принимает идентификатор пользователя и матрицу оценок в качестве входных данных. Она вычисляет схожесть пользователя с остальными пользователями, выбирает топ-N наиболее похожих пользователей и выдает рекомендации на основе их оценок.

Пример использования демонстрирует, как получить рекомендации фильмов для определенного пользователя. Результатом программы является список идентификаторов фильмов, которые рекомендуется пользователю с указанным идентификатором.

Заметьте, что в данном примере использована простая реализация коллаборативной фильтрации. В реальных приложениях рекомендательных систем может потребоваться более сложные алгоритмы и обработка больших объемов данных.

Пример более сложной реализации коллаборативной фильтрации с использованием алгоритма Singular Value Decomposition (SVD) для рекомендаций фильмов:

import numpy as np

from scipy.sparse import csr_matrix

from scipy.sparse.linalg import svds

# Пример матрицы оценок пользователей

ratings = np.array([

[5.0, 4.0, 0.0, 0.0, 0.0, 0.0],

[0.0, 0.0, 4.0, 0.0, 5.0, 0.0],

[0.0, 0.0, 0.0, 2.0, 4.0, 5.0],

[4.0, 0.0, 0.0, 0.0, 0.0, 4.0]

])

# Выполнение сингулярного разложения (SVD)

def perform_svd(ratings, k):

# Преобразование матрицы оценок в разреженную матрицу

sparse_ratings = csr_matrix(ratings)

# Применение SVD для получения матриц U, Sigma и Vt

U, Sigma, Vt = svds(sparse_ratings, k)

# Построение диагональной матрицы Sigma

Sigma = np.diag(Sigma)

return U, Sigma, Vt

# Функция рекомендации фильмов для пользователя

def recommend_movies(user_id, ratings, U, Sigma, Vt, num_recommendations=5):

user_ratings = ratings[user_id]

predicted_ratings = np.dot(np.dot(U[user_id, :], Sigma), Vt)

# Исключение уже оцененных фильмов из рекомендаций

predicted_ratings[user_ratings != 0] = -1

top_movies = np.argsort(predicted_ratings)[::-1][:num_recommendations]

return top_movies

# Пример использования

user_id = 0

k = 2 # Размерность скрытого пространства

U, Sigma, Vt = perform_svd(ratings, k)

recommended_movies = recommend_movies(user_id, ratings, U, Sigma, Vt)

print(f"Рекомендуемые фильмы для пользователя {user_id}:")

for movie_id in recommended_movies:

print(f"Фильм {movie_id}")

```

В данном примере используется алгоритм Singular Value Decomposition (SVD) для выполнения сингулярного разложения матрицы оценок пользователей. Полученные матрицы U, Sigma и Vt представляют собой аппроксимацию исходной матрицы оценок с использованием латентного пространства низкой размерности.

Функция `perform_svd` выполняет сингулярное разложение матрицы оценок с помощью функции `svds` из модуля `scipy.sparse.linalg`. Разложение возвращает матрицы U, Sigma и Vt.

Функция `recommend_movies` принимает идентификатор пользователя, матрицу оценок, а также матрицы U, Sigma и Vt в качестве аргументов. Она вычисляет предсказанные оценки для пользователя и рекомендует фильмы, имеющие наивысшие предсказанные оценки, исключая уже оцененные фильмы.

В приведенном примере выводится список рекомендованных фильмов для пользователя с идентификатором 0. Количество рекомендаций задается параметром `num_recommendations`.

Singular Value Decomposition (SVD), или Сингулярное разложение, является мощным алгоритмом линейной алгебры, который используется в различных областях, включая рекомендательные системы, сжатие данных, обработку изображений и многие другие.

Сингулярное разложение позволяет представить матрицу в виде произведения трех матриц: U, Sigma и Vt. Формально, для матрицы A размерности m x n SVD определяется следующим образом:

A = U * Sigma * Vt,

где U – матрица размерности m x m, содержащая левые сингулярные векторы,

Sigma – диагональная матрица размерности m x n, содержащая сингулярные значения,

Vt – транспонированная матрица размерности n x n, содержащая правые сингулярные векторы.

Сингулярные значения в матрице Sigma являются неотрицательными числами и упорядочены по убыванию. Они представляют собой меру важности каждого сингулярного вектора и определяют вклад каждого сингулярного вектора в исходную матрицу A.

При использовании SVD в рекомендательных системах, например, матрица A представляет собой матрицу оценок пользователей, где строки соответствуют пользователям, а столбцы – элементам (фильмам, продуктам и т.д.). SVD разделяет матрицу на скрытые факторы, представленные сингулярными векторами, и связывает их с пользователями и элементами. Это позволяет рекомендовать пользователям элементы, которые им могут понравиться, на основе сходства с другими пользователями или элементами.

Алгоритм SVD имеет несколько вариаций, которые могут быть использованы в зависимости от контекста и требований задачи. Некоторые из них включают Truncated SVD (SVD с ограниченным числом сингулярных значений), Implicit Matrix Factorization (IMF) и другие.

SVD является мощным инструментом для анализа данных и позволяет снизить размерность данных, извлекать важные признаки и находить скрытые паттерны. Вместе с тем, алгоритм SVD требует значительных вычислительных ресурсов и может столкнуться с проблемами при обработке больших объемов данных. Поэтому для больших наборов данных используются приближенные методы SVD или альтернативные алгоритмы, такие как алгоритмы матричной факторизации.

Однако, SVD по-прежнему остается важным инструментом в области рекомендательных систем и других задач, где требуется анализ больших матриц данных.

Контекстная фильтрация

Еще одним распространенным методом является контентная фильтрация. Контентная фильтрация – это метод рекомендательных систем, который основывается на анализе характеристик элементов и предпочтений пользователей. В контексте контентной фильтрации, каждый элемент (товар, статья, фильм и т.д.) характеризуется набором признаков или характеристик, которые описывают его содержание или свойства.

Процесс контентной фильтрации начинается с анализа характеристик элементов и их значимости для пользователей. Характеристики элементов могут включать такие атрибуты, как автор, жанр, ключевые слова, рейтинги и другие свойства, которые могут быть извлечены из содержания элемента или предоставлены вручную.

Далее, на основе характеристик элементов, строится профиль пользователя, который отражает его предпочтения и интересы. Профиль пользователя может быть создан путем анализа предыдущих взаимодействий пользователя с элементами, например, его рейтинги или история просмотров.

Затем, используя различные алгоритмы сходства, производится сравнение между профилем пользователя и характеристиками элементов. Целью является определение степени сходства между предпочтениями пользователя и характеристиками элементов.

На основе этого сравнения, система ранжирует и рекомендует пользователю элементы, которые наиболее соответствуют его предпочтениям. Например, если пользователь предпочитает фильмы определенного жанра, система может рекомендовать ему фильмы схожего жанра.

Преимуществом контентной фильтрации является то, что она не требует данных о предпочтениях других пользователей, так как она полностью основана на анализе характеристик элементов и предпочтениях пользователя. Это делает ее особенно полезной в случаях, когда у нас ограниченное количество данных о взаимодействиях пользователей.

Однако, контентная фильтрация также имеет свои ограничения. В частности, она может столкнуться с проблемой ограниченности характеристик элементов, особенно если характеристики не полностью охватывают аспекты предпочтений пользователя. Также возникает проблема обновления профиля пользователя и характеристик элементов с течением времени.

Метод является важным в рекомендательных систем, который позволяет рекомендовать пользователю элементы на основе их сходства с предпочтениями и характеристиками элементов. Она может быть эффективным инструментом в различных областях, таких как маркетинг, интернет-торговля, медиа и другие, где персонализированные рекомендации имеют важное значение для улучшения пользовательского опыта и увеличения продаж.

Рекомендательные системы также могут использовать гибридные подходы, комбинируя несколько методов для получения более точных и релевантных рекомендаций. Например, можно использовать коллаборативную фильтрацию для нахождения похожих пользователей и контентную фильтрацию для нахождения похожих элементов, и затем объединить результаты для формирования итоговых рекомендаций.

Рекомендательные системы являются мощным инструментом для улучшения пользовательского опыта, увеличения продаж и удержания клиентов. Они позволяют бизнесу создавать персонализированные рекомендации, основанные на данных и поведении пользователей, что способствует улучшению конкурентоспособности и достижению бизнес-целей.

Ниже приведен пример программы контентной фильтрации:

```python

# Импорт необходимых библиотек

import pandas as pd

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.metrics.pairwise import cosine_similarity

# Загрузка данных

data = pd.read_csv('movies.csv')

# Создание матрицы TF-IDF на основе описаний фильмов

tfidf = TfidfVectorizer(stop_words='english')

tfidf_matrix = tfidf.fit_transform(data['description'].fillna(''))

# Вычисление матрицы сходства косинусной мерой

cosine_sim = cosine_similarity(tfidf_matrix, tfidf_matrix)

# Функция для получения рекомендаций похожих фильмов

def get_recommendations(title, cosine_sim, data, top_n=5):

indices = pd.Series(data.index, index=data['title']).drop_duplicates()

idx = indices[title]

sim_scores = list(enumerate(cosine_sim[idx]))

sim_scores = sorted(sim_scores, key=lambda x: x[1], reverse=True)

sim_scores = sim_scores[1:top_n+1]

movie_indices = [i[0] for i in sim_scores]

return data['title'].iloc[movie_indices]

# Пример использования функции для получения рекомендаций

movie_title = 'The Dark Knight Rises'

recommendations = get_recommendations(movie_title, cosine_sim, data)

print(f"Рекомендации для фильма '{movie_title}':")

print(recommendations)

```

Программа выполняет следующие шаги:

1. Импортируются необходимые библиотеки. Библиотека `pandas` используется для работы с данными в виде таблицы, а библиотеки `TfidfVectorizer` и `cosine_similarity` из модуля `sklearn.feature_extraction.text` и `sklearn.metrics.pairwise` соответственно используются для работы с текстовыми данными и вычисления сходства между ними.

2. Загружаются данные о фильмах из файла 'movies.csv' с помощью функции `read_csv()` из библиотеки `pandas`. Данные обычно содержат информацию о фильмах, включая их названия, описания и другие атрибуты.

3. Создается объект `TfidfVectorizer`, который преобразует текстовые описания фильмов в числовые векторы с использованием метода TF-IDF. TF-IDF (Term Frequency-Inverse Document Frequency) – это статистическая мера, используемая для оценки важности термина в документе. Он позволяет выделить ключевые слова и характеристики фильмов.

4. С помощью метода `fit_transform()` объекта `TfidfVectorizer` преобразуется список описаний фильмов в матрицу TF-IDF. Эта матрица представляет собой числовое представление описаний фильмов, где каждый столбец соответствует определенному термину, а каждая строка – конкретному фильму.

5. Вычисляется матрица сходства между фильмами с использованием метода `cosine_similarity()` из модуля `sklearn.metrics.pairwise`. Косинусное сходство измеряет угол между двумя векторами и предоставляет меру их сходства. В данном случае, матрица сходства показывает степень сходства между каждой парой фильмов на основе их описаний.

6. Определяется функция `get_recommendations()`, которая принимает название фильма, матрицу сходства и данные о фильмах. Внутри функции происходит следующее:

– Создается объект `pd.Series` с индексами, соответствующими названиям фильмов и значениями, соответствующими их индексам в данных.

– Получается индекс выбранного фильма.

– Вычисляется список схожести выбранного фильма с остальными фильмами.

– Список сортируется по убыванию схожести.

– Выбираются топ-N фильмов на основе сходства.

– Возвращается список рекомендуемых фильмов.

7. Запрашивается у пользователя название фильма, для которого необходимо получить рекомендации.

8. Вызывается функция `get_recommendations()` с передачей ей названия фильма, матрицы сходства и данных о фильмах.

9. Выводятся на экран рекомендованные фильмы.

Программа использует алгоритм контентной фильтрации на основе TF-IDF и косинусного сходства для рекомендации фильмов на основе их текстовых описаний. Она преобразует текстовые данные в числовые векторы с использованием TF-IDF и затем вычисляет сходство между фильмами. Рекомендуемые фильмы выбираются на основе сходства с выбранным фильмом. Это позволяет предлагать пользователю фильмы, которые имеют схожие характеристики и описания с фильмами, которые он предпочитает.

Глава 3: Подготовка данных для машинного обучения

Качество данных определяет качество решений. Тщательная подготовка данных – залог успешного машинного обучения и эффективного бизнеса.

В процессе применения машинного обучения в бизнесе подготовка данных играет важную роль. Качество данных определяет эффективность моделей машинного обучения и точность результатов, которые они предоставляют. В этой главе мы рассмотрим различные аспекты и задачи, связанные с подготовкой данных, и объясним, почему они важны для бизнеса.

Одной из причин, почему мы будем рассматривать подготовку данных, является достижение высокого качества прогнозов и решений. Чистые и точные данные являются основой для создания моделей машинного обучения, которые могут давать надежные прогнозы и принимать обоснованные решения. Подготовка данных помогает устранить шум, выбросы и другие аномалии, что повышает точность прогнозов и решений.

Другой важной ролью подготовки данных является оптимизация бизнес-процессов. Анализ данных, включенный в процесс подготовки, позволяет лучше понять структуру и особенности данных. Это помогает оптимизировать бизнес-процессы и принимать обоснованные решения на основе данных. Например, анализ данных может выявить паттерны потребительского поведения, что позволит оптимизировать маркетинговые стратегии и улучшить взаимодействие с клиентами.

Также подготовка данных играет роль в персонализации и улучшении опыта клиента. Понимание предпочтений и потребностей клиентов на основе анализа данных позволяет создавать более персонализированные предложения и предлагать индивидуальные рекомендации. Это повышает уровень удовлетворенности клиентов и улучшает их опыт использования продуктов и услуг.

В данной главе мы рассмотрим различные задачи, связанные с подготовкой данных, включая сбор данных, очистку от шума и аномалий, анализ данных и обработку категориальных данных. Мы также рассмотрим методы и инструменты, которые помогут вам эффективно подготовить данные для использования в моделях машинного обучения.

3.1. Сбор, очистка и преобразование данныхВ мире машинного обучения и анализа данных сбор, очистка и преобразование данных играют ключевую роль. Эти этапы являются неотъемлемой частью подготовки данных перед применением алгоритмов машинного обучения. В этой главе мы рассмотрим, почему эти действия важны и как они влияют на результаты анализа данных и принятие решений в бизнесе.

Сбор данных является первым и наиболее важным шагом. Для успешного машинного обучения необходимо иметь доступ к качественным и репрезентативным данным. Это может включать данные о клиентах, продуктах, транзакциях, рекламе и многом другом, в зависимости от конкретной задачи и области бизнеса. Сбор данных может осуществляться различными способами, включая опросы, сенсоры, базы данных, API и многое другое. Цель состоит в том, чтобы получить максимально полные и точные данные, которые позволят нам выявить закономерности и сделать правильные выводы.

Однако сырые данные не всегда готовы к использованию. Часто они содержат ошибки, пропуски, выбросы и другие неточности. Поэтому следующим шагом является очистка данных. Очистка данных включает в себя удаление или исправление ошибочных значений, заполнение пропущенных данных, удаление выбросов и приведение данных к единообразному формату. Цель состоит в том, чтобы убрать нежелательные влияния, которые могут исказить результаты анализа и прогнозирования.

После очистки данных часто требуется их преобразование. Преобразование данных может включать изменение формата, масштабирование, создание новых признаков и многое другое. Например, числовые данные могут быть нормализованы, чтобы привести их к одному диапазону значений, или категориальные данные могут быть закодированы с использованием метода One-Hot Encoding для использования в алгоритмах машинного обучения. Преобразование данных позволяет создать более информативные и удобные для анализа наборы данных, а также улучшить производительность моделей машинного обучения.

Важно понимать, что сбор, очистка и преобразование данных являются итеративным процессом. В ходе анализа данных и разработки моделей могут возникать новые требования и потребности, которые потребуют обновления и доработки данных. Поэтому эти этапы являются непрерывным процессом, который требует внимания и усилий на протяжении всего жизненного цикла проекта. Понимание и умение применять эти методы позволит нам получить качественные данные и обеспечить надежные результаты анализа данных в бизнесе.

3.1.1. Сбор данныхРаздел о сборе данных является важной частью подготовки данных для машинного обучения. Он занимается определением источников данных и разработкой методов их сбора.

Один из основных аспектов сбора данных – это определение необходимых данных для анализа и прогнозирования. В бизнесе может быть множество различных типов данных, которые могут быть полезными для принятия решений, например, данные о клиентах, продажах, финансовых показателях или маркетинговых активностях. Важно определить, какие данные являются релевантными для вашей задачи и какие источники можно использовать для их получения.