Обработка больших данных

HBase использует модель данных, основанную на колонках, что отличается от традиционных реляционных баз данных, использующих строки и таблицы. В HBase данные хранятся в таблицах, которые делятся на строки и колонки, при этом каждая ячейка может хранить данные разного типа и иметь разное количество версий. Такая структура позволяет эффективно выполнять запросы к данным, поддерживать низкую задержку и обрабатывать данные с высокой скоростью, что делает HBase идеальным для использования в реальном времени, а также в аналитических приложениях, где требуется быстрый доступ к данным.

Одной из ключевых особенностей HBase является его способность масштабироваться горизонтально. Это достигается за счет распределенной архитектуры, в которой данные распределяются по нескольким узлам кластера. Каждый узел в кластере HBase выполняет роль RegionServer и хранит определенные части данных, называемые регионами. Эти регионы автоматически распределяются и балансируются между различными узлами кластера, что позволяет HBase справляться с увеличением объема данных и числа запросов. В дополнение к этому, HBase поддерживает репликацию данных для обеспечения высокой доступности и отказоустойчивости, что делает систему надежной даже в случае сбоя отдельных узлов.

HBase работает поверх HDFS, что позволяет использовать его возможности для хранения и управления большими объемами данных, эффективно используя распределенные ресурсы Hadoop. HDFS обеспечивает высокую надежность хранения данных и позволяет HBase эффективно работать с данными, хранящимися в распределенной файловой системе. Взаимодействие между HBase и HDFS позволяет пользователям использовать преимущества обоих инструментов: HBase для быстрого доступа и обработки данных, и HDFS для надежного и масштабируемого хранения.

HBase представляет собой мощный инструмент для работы с большими данными, предоставляя возможности для хранения и обработки данных в реальном времени, что особенно полезно в сценариях, где требуется высокая производительность и масштабируемость, таких как веб-приложения, анализ больших данных и обработка транзакций в реальном времени.

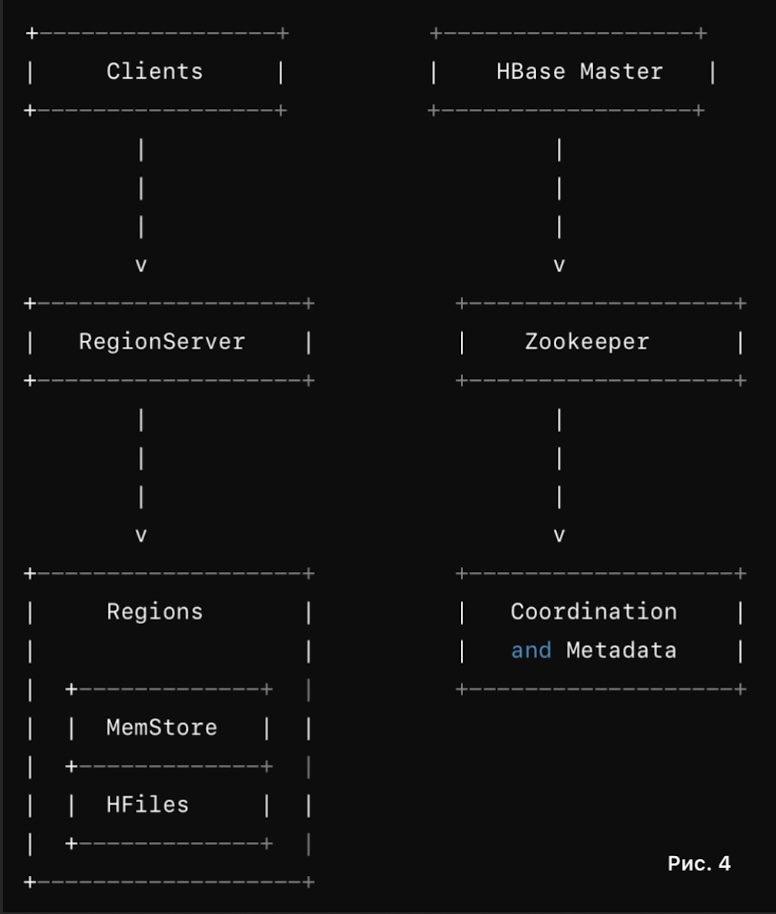

HBase обеспечивает эффективное хранение и обработку данных, используя распределенную архитектуру и ключевые компоненты, такие как RegionServer, HBase Master и Zookeeper. Процесс записи данных начинается с того, что клиент отправляет запрос на запись в HBase. Запрос сначала поступает к HBase Master, который определяет соответствующий RegionServer. На этом сервере данные попадают в MemStore, временное хранилище в памяти, где они накапливаются до тех пор, пока MemStore не заполнится. Затем данные записываются в HFile на диск, где они организованы по колонкам для оптимизации хранения и быстрого доступа. После записи в HFile, MemStore очищается, чтобы освободить место для новых данных. (Рис. 4)

При чтении данных клиент отправляет запрос на чтение, который также направляется к HBase Master для определения нужного RegionServer. На RegionServer данные сначала ищутся в MemStore. Если требуемые данные не найдены в MemStore, производится поиск в HFiles, которые хранят данные на диске. Результаты из MemStore и HFiles объединяются и возвращаются клиенту, обеспечивая точный и быстрый доступ к информации.

HBase также управляет балансировкой нагрузки и репликацией данных для обеспечения надежности и масштабируемости. HBase Master отвечает за распределение регионов между RegionServer, чтобы равномерно распределить нагрузку и избежать перегрузки отдельных узлов. Репликация данных обеспечивает отказоустойчивость, так как копии данных хранятся на нескольких RegionServer, что гарантирует доступность данных даже в случае сбоя узлов.

Zookeeper играет важную роль в координации и управлении HBase. Он отслеживает состояние RegionServer, управляет метаданными и помогает в выборе лидера и синхронизации между компонентами системы. Все запросы клиентов обрабатываются через HBase Master, который направляет их к соответствующим RegionServer. Региональные серверы обрабатывают запросы, взаимодействуя с MemStore и HFiles, и могут обращаться к Zookeeper для координации. HBase Master и Zookeeper работают вместе, чтобы обеспечить эффективное и масштабируемое хранение и обработку данных.

– ZooKeeper

ZooKeeper – это специализированный сервис, предназначенный для координации и управления конфигурацией в распределенных приложениях. Он был разработан для упрощения и повышения надежности взаимодействия между различными компонентами распределенных систем, которые могут быть разбросаны по множеству узлов. В основе работы ZooKeeper лежит идея предоставления централизованного сервиса для управления конфигурацией, синхронизации процессов и координации распределенных задач.

Одна из ключевых функций ZooKeeper – обеспечение надежной и согласованной конфигурации для распределенных приложений. В больших распределенных систем часто возникают проблемы с синхронизацией конфигурационных данных между разными узлами, что может приводить к сбоям или некорректной работе приложения. ZooKeeper решает эту проблему, предоставляя единое место, где хранятся все конфигурационные данные и метаданные. Узлы системы могут обращаться к ZooKeeper для получения актуальной конфигурации и оперативно обновлять свои настройки при изменении конфигурации, что гарантирует согласованность данных по всей системе.

Кроме того, ZooKeeper играет важную роль в обеспечении синхронизации и координации распределенных процессов. В распределенных системах часто возникают задачи, требующие синхронизации между различными узлами, такие как выбор лидера, блокировка ресурсов или координация выполнения задач. ZooKeeper предоставляет механизмы для реализации этих задач, включая локации, семафоры и уведомления о событиях. Например, при необходимости выбрать лидера из набора узлов, ZooKeeper может управлять этим процессом, гарантируя, что в любой момент времени существует только один активный лидер и что все узлы согласованы относительно текущего лидера.

ZooKeeper использует концепцию "znode" – элементов иерархической структуры, которые хранят данные и метаданные. Узлы в ZooKeeper могут быть листовыми (хранят данные) или промежуточными (служат для организации структуры). Эта иерархическая структура позволяет эффективно управлять конфигурацией и синхронизацией, так как все узлы системы имеют доступ к актуальной информации о состоянии и конфигурации через ZooKeeper. Когда данные или конфигурация изменяются, ZooKeeper оповещает все заинтересованные узлы о произошедших изменениях, что обеспечивает своевременное обновление информации по всей системе.

ZooKeeper обеспечивает надежное и эффективное управление конфигурацией и координацию процессов в распределенных системах, что является критически важным для обеспечения их стабильности и согласованности. Его способность централизованно управлять данными и синхронизацией делает его неотъемлемым инструментом для современных распределенных приложений, таких как Apache Hadoop, Apache HBase и других технологий, которые требуют координации между множеством узлов и процессов.

Основные компоненты и их функции (Рис. 5)

Clients (Приложения): Приложения и распределенные системы (например, Apache HBase, Apache Kafka) взаимодействуют с ZooKeeper для получения конфигурационных данных, синхронизации и координации. Клиенты отправляют запросы и получают обновления через ZooKeeper.

ZooKeeper Ensemble (Кластер): ZooKeeper Nodes (Узлы ZooKeeper): Кластер состоит из нескольких узлов ZooKeeper, которые работают совместно для обеспечения высокой доступности и отказоустойчивости. Каждый узел хранит копию данных и метаданных, и все узлы работают вместе для обработки запросов от клиентов.

Узлы ZooKeeper используют протокол согласования для поддержания согласованности данных между собой. В случае сбоя одного из узлов, остальные продолжают работать, обеспечивая надежность системы.

ZNodes (Данные): ZooKeeper хранит данные в иерархической структуре узлов, называемых ZNodes. Эти узлы могут быть:

Листовые узлы: Хранят данные (например, конфигурации или значения).

Промежуточные узлы: Используются для создания структуры и организации данных.

Примеры ZNodes:

/ (корневой узел): Начальная точка иерархии.

/config: Узел, содержащий конфигурационные данные.

/locks: Узел для управления блокировками и синхронизацией ресурсов.

/leaders: Узел для координации и выбора лидера в распределенной системе.

Процесс работы

Запросы от клиентов: Клиенты отправляют запросы к кластеру ZooKeeper для получения данных, обновления конфигураций или синхронизации. Запросы могут быть на чтение или запись данных, управление блокировками и т.д.

Обработка запросов: Узлы ZooKeeper обрабатывают запросы от клиентов и возвращают необходимые данные. Если данные изменяются, ZooKeeper обновляет соответствующие ZNodes и оповещает клиентов об изменениях.

Координация и синхронизация: Когда данные в ZNodes изменяются, ZooKeeper уведомляет все клиенты, которые подписаны на эти изменения. Это позволяет поддерживать согласованность конфигурации и синхронизацию процессов в распределенных системах.

Управление и отказоустойчивость: ZooKeeper использует кластер из нескольких узлов для обеспечения высокой доступности и отказоустойчивости. Если один узел выходит из строя, другие узлы продолжают обслуживать запросы, обеспечивая надежность и непрерывность работы.

Эта схема помогает визуализировать, как ZooKeeper управляет данными и координирует процессы в распределенных системах, обеспечивая централизованное и надежное решение для управления конфигурацией и синхронизацией.

Кроме основных компонентов Hadoop, существует множество других сопутствующих технологий и инструментов, таких как Apache Spark (для быстрой обработки данных в памяти), Apache Kafka (для потоковой передачи данных), и другие, которые расширяют возможности работы с большими данными, делая их обработку и анализ более эффективными и масштабируемыми.

Описание компонентов на схеме (Рис. 6).

1. Clients (Приложения): Запускают задачи и запросы на обработку данных.

2. Hadoop Framework (Фреймворк Hadoop): Включает YARN для управления ресурсами и планирования задач, а также HDFS для распределенного хранения данных.

3. Data Storage (Хранение данных): HDFS (Hadoop Distributed File System) хранит данные в распределенной файловой системе.

4. Data Processing (Обработка данных): MapReduce парадигма обработки данных, распределяющая задачи по узлам кластера.

– HBase: NoSQL база данных для реального времени и быстрого доступа к данным.

– Pig/Hive: Инструменты для обработки данных и выполнения запросов, где Pig использует язык скриптов, а Hive – SQL-подобные запросы.

Схема иллюстрирует взаимодействие между основными компонентами экосистемы Hadoop, обеспечивая хранение, обработку и управление данными.

Преимущества и вызовы больших данных

Использование больших данных (Big Data) имеет множество преимуществ, которые оказывают значительное влияние на различные сферы бизнеса, науки и общества в целом. Большие данные представляют собой огромные объемы информации, поступающие из разнообразных источников, таких как социальные сети, датчики, транзакционные системы, интернет вещей (IoT) и другие. Эти данные могут быть структурированными и неструктурированными, и благодаря современным технологиям их можно анализировать и извлекать из них полезную информацию.

Улучшение принятия решений

Одним из ключевых преимуществ использования больших данных является возможность улучшения процесса принятия решений. Анализ больших объемов данных позволяет организациям выявлять скрытые паттерны и тенденции, которые не были бы очевидны при использовании традиционных методов анализа. Это, в свою очередь, помогает компаниям принимать более обоснованные и информированные решения, снижая уровень неопределенности и риска. Например, анализ поведения потребителей и рыночных тенденций с помощью больших данных позволяет компаниям разрабатывать более эффективные маркетинговые стратегии и предлагать продукты, которые лучше соответствуют потребностям клиентов.

Повышение операционной эффективности

Большие данные играют важную роль в оптимизации бизнес-процессов и повышении операционной эффективности. С помощью анализа данных можно выявить узкие места и неэффективности в производственных и управленческих процессах, что позволяет предприятиям совершенствовать свои операции и снижать затраты. Например, в производственных секторах анализ данных о производительности оборудования может помочь в прогнозировании необходимости технического обслуживания и предотвращении поломок, что снижает простои и улучшает общую производительность.

Развитие персонализации и улучшение клиентского опыта

Большие данные также способствуют развитию персонализации продуктов и услуг, что является важным аспектом современного бизнеса. С помощью анализа данных о поведении пользователей, их предпочтениях и привычках компании могут предлагать более индивидуализированные и релевантные предложения, что повышает удовлетворенность клиентов и их лояльность. Например, стриминговые сервисы, такие как Netflix или Spotify, используют данные о предпочтениях пользователей для создания персонализированных рекомендаций, что способствует увеличению времени, проводимого пользователями на платформе.

Инновации и развитие новых продуктов и услуг

Анализ больших данных открывает новые возможности для инноваций и создания новых продуктов и услуг. Компании могут использовать данные для понимания рыночных тенденций и предпочтений потребителей, что помогает им разрабатывать инновационные решения, которые лучше соответствуют потребностям рынка. В фармацевтической промышленности, например, анализ больших данных позволяет ускорить процесс разработки новых лекарственных средств, анализируя данные клинических испытаний и генетическую информацию пациентов.

Поддержка научных исследований и прогнозирования

В науке и исследованиях большие данные играют ключевую роль в сборе и анализе информации, что позволяет ученым делать более точные прогнозы и выводы. В таких областях, как климатология, биология, астрономия и медицина, большие данные помогают в анализе сложных систем и явлений, что способствует развитию науки и технологии. Например, использование больших данных в медицинских исследованиях позволяет выявлять новые связи между генетическими факторами и заболеваниями, что способствует разработке более точных методов диагностики и лечения.

Преимущества использования больших данных очевидны и многообразны. Они позволяют улучшить процессы принятия решений, повысить операционную эффективность, развивать персонализацию, стимулировать инновации и поддерживать научные исследования. Однако, важно помнить, что для эффективного использования больших данных необходимы соответствующие технологии, инфраструктура и квалифицированные специалисты, способные извлекать ценные инсайты из огромных объемов информации.

Использование больших данных (Big Data) приносит значительные преимущества, но также сопряжено с рядом вызовов и проблем. Основные трудности связаны с хранением, обработкой и безопасностью данных. Рассмотрим каждую из этих проблем более подробно.

1. Проблемы хранения данных

Хранение больших данных представляет собой значительную задачу из-за объема и разнообразия данных, которые необходимо сохранять. Современные компании собирают информацию из множества источников, включая транзакционные системы, социальные сети, сенсоры, устройства Интернета вещей (IoT) и многое другое. Это приводит к созданию огромных массивов данных, которые могут занимать петабайты или даже эксабайты пространства.

Основные вызовы хранения данных включают:

Хранение данных в эпоху больших данных (Big Data) сталкивается с рядом серьезных вызовов, связанных с объемами, разнообразием и требованиями к скорости доступа к данным. Каждый из этих вызовов требует инновационных решений и новых подходов для обеспечения эффективного управления и использования данных.

– Объем данных

С ростом объемов данных требования к их хранению увеличиваются экспоненциально. Компании и организации генерируют и собирают данные с невиданной ранее скоростью – объемы данных могут достигать нескольких петабайт и даже эксабайт. Традиционные системы хранения, такие как локальные серверы и жесткие диски, быстро исчерпывают свои возможности при таких объемах. Эти системы не только ограничены по емкости, но и требуют значительных затрат на обслуживание и масштабирование.

Чтобы справиться с возрастающими объемами данных, все больше организаций переходит на облачные решения и распределенные системы хранения. Облачные платформы, такие как Amazon Web Services (AWS), Microsoft Azure и Google Cloud Platform, предлагают практически неограниченные возможности для хранения данных, гибкость в масштабировании и управление данными на основе "платишь по мере использования". Использование облачных решений позволяет снизить затраты на инфраструктуру и обеспечить высокую доступность данных. Тем не менее, облачные технологии требуют дополнительных мер безопасности и защиты данных, что становится отдельной задачей для организаций.

– Разнообразие данных

Одним из ключевых вызовов хранения данных является их разнообразие. Большие данные включают в себя структурированные данные (такие как базы данных и таблицы), неструктурированные данные (такие как текстовые документы, изображения, видео) и полуструктурированные данные (такие как XML-файлы и JSON-данные). Каждый из этих типов данных требует специфических методов хранения и управления.

Структурированные данные обычно хранятся в традиционных реляционных базах данных, таких как MySQL или PostgreSQL, которые обеспечивают эффективные методы для управления и запросов. Неструктурированные данные, напротив, требуют хранения в системах, способных обрабатывать большие и разнообразные объемы информации, таких как системы управления контентом (CMS) или распределенные файловые системы, такие как Hadoop Distributed File System (HDFS) и NoSQL базы данных, например, MongoDB и Cassandra.

Кроме того, полуструктурированные данные, которые сочетают элементы как структурированных, так и неструктурированных данных, часто хранятся в гибридных хранилищах, таких как базы данных документов и графов. Управление таким разнообразием данных требует не только специальных систем хранения, но и квалифицированного персонала, который способен эффективно организовать работу с различными типами данных.

– Скорость доступа

Еще одним критически важным аспектом хранения данных является обеспечение высокой скорости доступа к данным. В эпоху больших данных многие организации зависят от анализа данных в реальном времени для принятия стратегических решений, оптимизации бизнес-процессов и повышения уровня обслуживания клиентов. Например, компании, занимающиеся электронной коммерцией, используют данные в реальном времени для анализа поведения клиентов и настройки маркетинговых стратегий. В таких случаях медленный доступ к данным может привести к потере конкурентных преимуществ и снижению эффективности бизнеса.

Для обеспечения высокой скорости доступа к данным используются такие технологии, как in-memory computing (вычисления в оперативной памяти), распределенные системы кеширования (например, Redis, Memcached) и технологии edge computing, которые позволяют обрабатывать данные ближе к источнику их возникновения. Кроме того, оптимизация хранения данных, включающая индексацию и партиционирование данных, также играет важную роль в повышении скорости доступа.

Однако с ростом объема данных усложняется процесс обеспечения быстрого и эффективного доступа к ним. Это требует не только значительных инвестиций в высокопроизводительное оборудование и программное обеспечение, но и разработки сложных алгоритмов и архитектур данных, которые могут справляться с этими вызовами.

В условиях стремительного роста объемов, разнообразия и требований к скорости доступа к данным, традиционные методы хранения становятся недостаточными. Для эффективного управления большими данными необходимы инновационные решения, такие как облачные технологии, распределенные системы и специализированное программное обеспечение, а также комплексный подход к управлению безопасностью и конфиденциальностью данных. Решение этих вызовов требует не только внедрения новых технологий, но и стратегического подхода к организации хранения и обработки данных, что позволит полностью реализовать потенциал больших данных.

2. Проблемы обработки данных

Обработка больших данных представляет еще один важный вызов. В процессе обработки необходимо не только обрабатывать огромные объемы информации, но и делать это эффективно и в реальном времени, что часто требует значительных вычислительных ресурсов.

Основные вызовы обработки данных включают:

Обработка больших данных (Big Data) сопряжена с множеством вызовов, среди которых особое место занимают вопросы скорости обработки, качества данных и сложности анализа. Эти вызовы требуют современных подходов и технологий для обеспечения эффективного анализа и использования больших объемов информации.

– Скорость обработки

Одним из основных вызовов обработки больших данных является необходимость в высокой скорости вычислений. В современном мире многие компании и организации зависят от анализа данных в реальном времени, будь то для мониторинга систем, принятия стратегических решений или оптимизации бизнес-процессов. Обработка больших объемов данных в реальном времени требует мощных вычислительных ресурсов и специальных методов, способных быстро обрабатывать огромные массивы информации.

Традиционные методы обработки данных, такие как централизованные базы данных и последовательные алгоритмы, часто оказываются неэффективными при работе с большими данными. Это связано с тем, что такие методы не могут справиться с объемами данных, которые поступают со скоростью терабайты в секунду, или не обеспечивают достаточную производительность для обработки данных в реальном времени. Для решения этой проблемы используются распределенные вычислительные системы, такие как Apache Hadoop и Apache Spark, которые позволяют разделять большие объемы данных на более мелкие части и обрабатывать их параллельно. Это существенно ускоряет процесс обработки и позволяет работать с большими данными более эффективно.

Однако использование распределенных систем требует значительных вычислительных мощностей и специализированных навыков для управления и оптимизации таких систем. Кроме того, распределенные системы обработки данных нуждаются в надежной инфраструктуре и поддержке, что также является серьезным вызовом для организаций.

– Качество данных

Еще одним важным вызовом при обработке больших данных является обеспечение их качества. Большие данные часто поступают из различных источников, таких как сенсоры, социальные сети, транзакционные системы и интернет вещей (IoT). В связи с этим данные могут содержать ошибки, пропущенные значения, дубликаты или несоответствия, что делает их анализ более сложным и может приводить к неправильным выводам.

Для обеспечения точности и надежности анализа необходимо проводить тщательную очистку данных. Процесс очистки включает в себя несколько этапов, таких как удаление дубликатов, исправление ошибок, замена пропущенных значений и нормализация данных. Эти задачи могут быть крайне трудоемкими и ресурсоемкими, особенно когда речь идет о больших объемах данных.

Автоматизация процесса очистки данных с использованием алгоритмов машинного обучения и искусственного интеллекта может помочь ускорить этот процесс, но она также требует значительных усилий по разработке и обучению моделей. Кроме того, необходимо учитывать специфические требования к данным в различных отраслях и сценариях использования, что делает процесс очистки еще более сложным и затратным.

– Сложность анализа

Анализ больших данных представляет собой еще один вызов, связанный с их сложностью и многомерностью. Большие данные часто включают множество переменных и имеют сложные структуры, которые трудно анализировать с помощью традиционных методов. Например, данные могут включать временные ряды, пространственные данные, данные о поведении пользователей и многие другие типы данных, которые требуют специальных методов анализа.

Для решения этой проблемы требуются новые методы и инструменты анализа данных. Машинное обучение и искусственный интеллект стали ключевыми технологиями для работы с большими данными. Они позволяют автоматизировать процесс анализа и находить скрытые закономерности и корреляции в данных, которые не видны при использовании традиционных методов. Например, алгоритмы глубокого обучения могут эффективно работать с большими объемами данных, такими как изображения или тексты, и находить сложные зависимости между переменными.