Нейросети. Обработка естественного языка

2. Извлечение признаков: При скольжении фильтров по тексту они извлекают локальные признаки. Например, один фильтр может выделять биграммы (пары слов), а другой – триграммы (три слова подряд). Фильтры "апроксимируют" части текста, выявляя важные структуры, такие как фразы, ключевые слова или грамматические конструкции.

3. Свертка и пулинг: После применения фильтров, результаты свертки подвергаются операции пулинга (pooling). Пулинг уменьшает размерность данных, оставляя только наиболее важные признаки. Операция Max-Pooling, например, выбирает максимальное значение из группы значений, что позволяет выделить самые значимые признаки.

4. Слои полносвязной нейронной сети: После извлечения признаков из текста через сверточные слои, результаты передаются на полносвязные слои нейронной сети. Эти слои выполняют классификацию, регрессию или другие задачи в зависимости от поставленной задачи. Для анализа текста это может быть задачей классификации текстов на категории или определения тональности.

Пример кода для анализа текста с использованием сверточных слоев на Python и библиотеке TensorFlow/Keras:

import tensorflow as tf

from tensorflow.keras.layers import Embedding, Conv1D, GlobalMaxPooling1D, Dense

from tensorflow.keras.models import Sequential

from tensorflow.keras.preprocessing.text import Tokenizer

from tensorflow.keras.preprocessing.sequence import pad_sequences

import numpy as np

# Генерируем синтетический датасет для примера

texts = ["Этот фильм был ужасным!", "Отличный фильм, рекомендую.", "Сюжет оставляет желать лучшего."]

# Метки классов (положительный, отрицательный)

labels = [0, 1, 0]

# Токенизация и векторизация текстов

tokenizer = Tokenizer(num_words=1000)

tokenizer.fit_on_texts(texts)

sequences = tokenizer.texts_to_sequences(texts)

# Подготовка данных для модели

max_sequence_length = max([len(seq) for seq in sequences])

padded_sequences = pad_sequences(sequences, maxlen=max_sequence_length)

# Создание модели CNN для анализа текста

model = Sequential()

model.add(Embedding(input_dim=len(tokenizer.word_index) + 1, output_dim=100, input_length=max_sequence_length))

model.add(Conv1D(32, 3, activation='relu')) # Изменено ядро с 5 на 3 и количество фильтров с 128 на 32

model.add(GlobalMaxPooling1D())

model.add(Dense(1, activation='sigmoid'))

# Компиляция модели

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# Обучение модели

x_train = padded_sequences

y_train = np.array(labels)

model.fit(x_train, y_train, epochs=10)

# Оценка модели

test_text = ["Это лучший фильм, который я когда-либо видел!"]

test_sequence = tokenizer.texts_to_sequences(test_text)

padded_test_sequence = pad_sequences(test_sequence, maxlen=max_sequence_length)

result = model.predict(padded_test_sequence)

print("Результат анализа текста:", result)

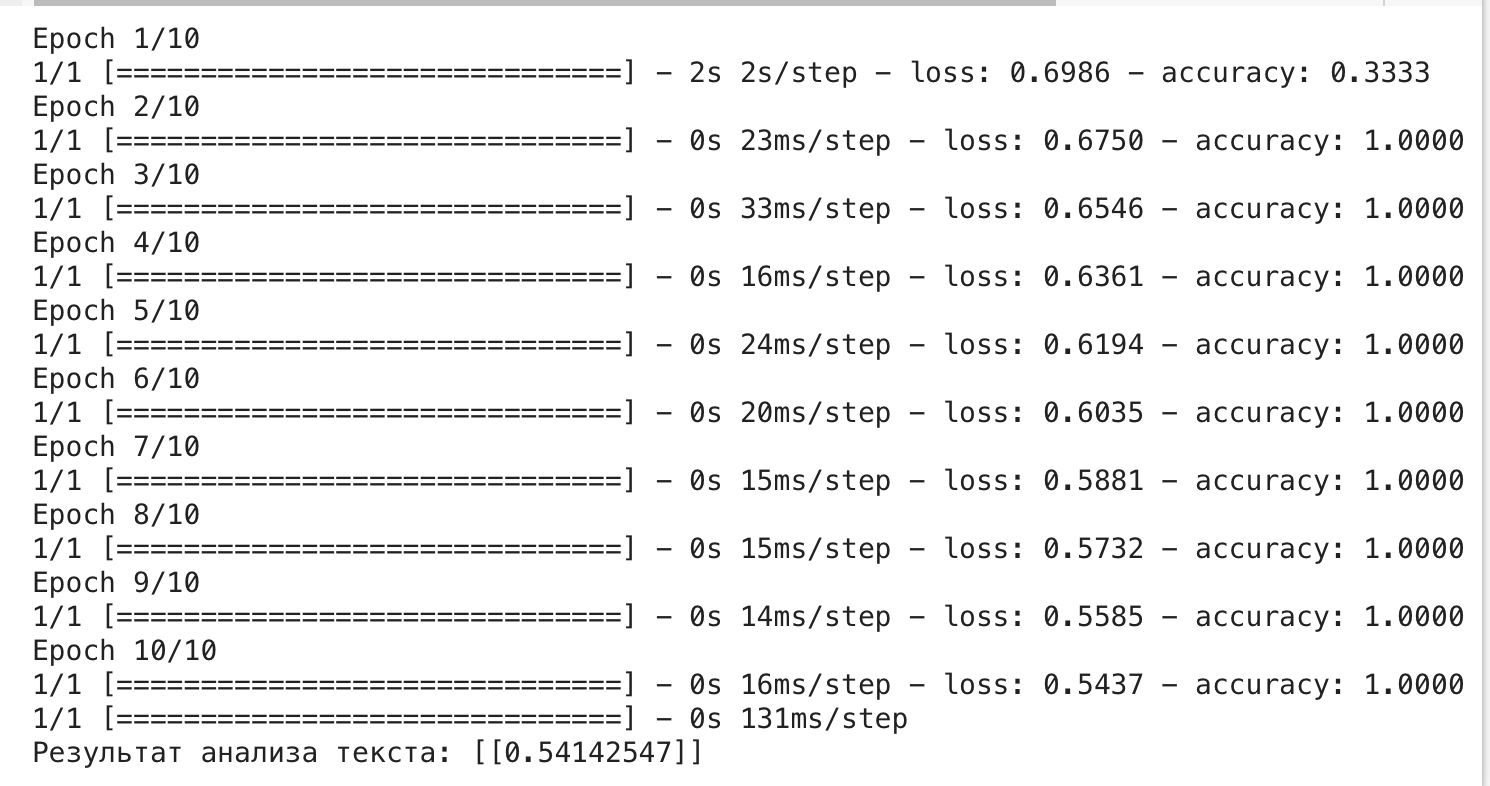

В данном примере результатом будет число от 0 до 1, которое показывает вероятность положительного обзора. Например, если результат равен 0.85, это означает, что модель оценивает текст как положительный с вероятностью 85%. Если результат близок к 0, это означает, что текст скорее всего отрицательный, а если близок к 1, то текст скорее всего положительный.

Этот код создает простую модель CNN для анализа тональности текстов. Обратите внимание, что для реальных данных потребуется больше данных и тонкая настройка модели для достижения высокой точности.

– Обработка последовательностей:

Сверточные нейронные сети (CNN), изначально разработанные для обработки изображений, также могут быть применены к текстовым данным. Для этого текст обрабатывается как последовательность символов или слов, и каждый элемент последовательности (символ или слово) кодируется в числовой форме. Затем текст преобразуется в матрицу, где каждый столбец соответствует символу или слову, а строки – контекстным окнам (например, наборам слов или символов).

Давайте рассмотрим этот процесс более подробно:

Кодирование текста: Сначала текст кодируется в числовую форму. Это может быть выполнено с использованием токенизации, при которой каждому уникальному слову или символу назначается уникальное числовое значение (индекс). Эти числовые значения представляют слова или символы в числовой форме.

Представление в виде матрицы: Кодированный текст представляется в виде матрицы, где каждый столбец соответствует слову или символу, а строки представляют контекстные окна. Это означает, что каждая строка матрицы представляет собой последовательность слов или символов из исходного текста. Размерность матрицы зависит от размера контекстного окна и размера словаря (количество уникальных слов или символов).

Сверточные слои: Сверточные слои в CNN применяются к матрице, чтобы извлечь важные признаки из текста. Свертка происходит путем сканирования фильтров (ядер свертки) через матрицу. Эти фильтры могут выявлять различные шаблоны и особенности в тексте, такие как последовательности слов или символов. Результатом свертки является новая матрица, называемая картой признаков (feature map).

Пулинг (Pooling): После применения сверточных слоев может выполняться операция пулинга. Пулинг используется для уменьшения размерности карты признаков, уменьшая количество параметров и улучшая обобщающую способность модели. Обычно используется операция максимального пулинга (MaxPooling), которая выделяет наибольшие значения из окна, перемещая его по карте признаков.

Полносвязные слои: После применения сверточных и пулинговых слоев информация передается в полносвязные слои для классификации или регрессии. Полносвязные слои работают с вектором признаков, полученным из карты признаков после операции пулинга.

Преимущество использования CNN для текстовых данных заключается в способности модели извлекать локальные и глобальные признаки из текста, что может улучшить способность модели к анализу и классификации текста. Этот метод также позволяет модели работать с последовательностями разной длины, благодаря использованию окон и пулинга.

Следующий код решает задачу бинарной классификации текстовых отзывов на положительные и отрицательные. Каждый отзыв имеет метку 1 (положительный) или 0 (отрицательный).

В результате выполнения этого кода:

1. Мы создаем модель сверточной нейронной сети (CNN), которая способна анализировать тексты.

2. Загружаем обучающие данные в виде массива текстов `texts` и их меток `labels`.

3. Создаем токенизатор для преобразования текстов в численные последовательности и приводим тексты к числовому представлению.

4. Выравниваем текстовые последовательности до максимальной длины `max_sequence_length`, чтобы их можно было использовать в нейронной сети.

5. Создаем модель CNN, состоящую из слоев Embedding, Conv1D, GlobalMaxPooling1D и Dense.

6. Компилируем модель, используя оптимизатор "adam" и функцию потерь "binary_crossentropy".

7. Обучаем модель на обучающих данных в течение 10 эпох.

8. Оцениваем модель на тестовых данных (4 отдельных отзыва).

Результаты этого кода включают в себя точность модели на тестовых данных, которая измеряет, насколько хорошо модель классифицирует новые отзывы как положительные или отрицательные. Вы увидите значение точности на тестовых данных в консоли после выполнения кода. Точность ближе к 1.0 означает, что модель хорошо обучена и способна правильно классифицировать тексты.

import tensorflow as tf

import numpy as np

import matplotlib.pyplot as plt

# Генерируем примеры текстовых данных

texts = ["Это отличный продукт.", "Этот товар ужасен.", "Мне нравится эта книга.", "Не советую этот фильм."]

labels = [1, 0, 1, 0] # 1 – положительный отзыв, 0 – отрицательный отзыв

# Создаем токенизатор и преобразуем тексты в последовательности чисел

tokenizer = tf.keras.preprocessing.text.Tokenizer(num_words=1000, oov_token="

tokenizer.fit_on_texts(texts)

sequences = tokenizer.texts_to_sequences(texts)

# Подготавливаем данные для CNN

max_sequence_length = max([len(seq) for seq in sequences])

padded_sequences = tf.keras.preprocessing.sequence.pad_sequences(sequences, maxlen=max_sequence_length)

# Преобразуем метки в массив numpy

labels = np.array(labels)

# Создаем модель CNN

model = tf.keras.Sequential([

tf.keras.layers.Embedding(input_dim=1000, output_dim=16, input_length=max_sequence_length),

tf.keras.layers.Conv1D(128, 3, activation='relu'), # Уменьшили размер ядра до 3

tf.keras.layers.GlobalMaxPooling1D(),

tf.keras.layers.Dense(1, activation='sigmoid')

])

# Компилируем модель

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# Обучаем модель

history = model.fit(padded_sequences, labels, epochs=10, verbose=1)

# Оцениваем модель на тестовых данных

test_texts = ["Это лучшая книга.", "Не стоит тратить деньги.", "Мне понравился фильм.", "Ужасное качество товара."]

test_labels = [1, 0, 1, 0] # Метки для тестовых данных

test_sequences = tokenizer.texts_to_sequences(test_texts)

padded_test_sequences = tf.keras.preprocessing.sequence.pad_sequences(test_sequences, maxlen=max_sequence_length)

test_labels = np.array(test_labels)

test_loss, test_accuracy = model.evaluate(padded_test_sequences, test_labels)

print(f"Точность на тестовых данных: {test_accuracy:.4f}")

# Визуализация результатов

plt.figure(figsize=(12, 4))

plt.subplot(1, 2, 1)

plt.plot(history.history['accuracy'], label='Точность на обучении')

plt.xlabel('Эпохи')

plt.ylabel('Точность')

plt.legend()

plt.subplot(1, 2, 2)

plt.plot(history.history['loss'], label='Потери на обучении')

plt.xlabel('Эпохи')

plt.ylabel('Потери')

plt.legend()

plt.show()

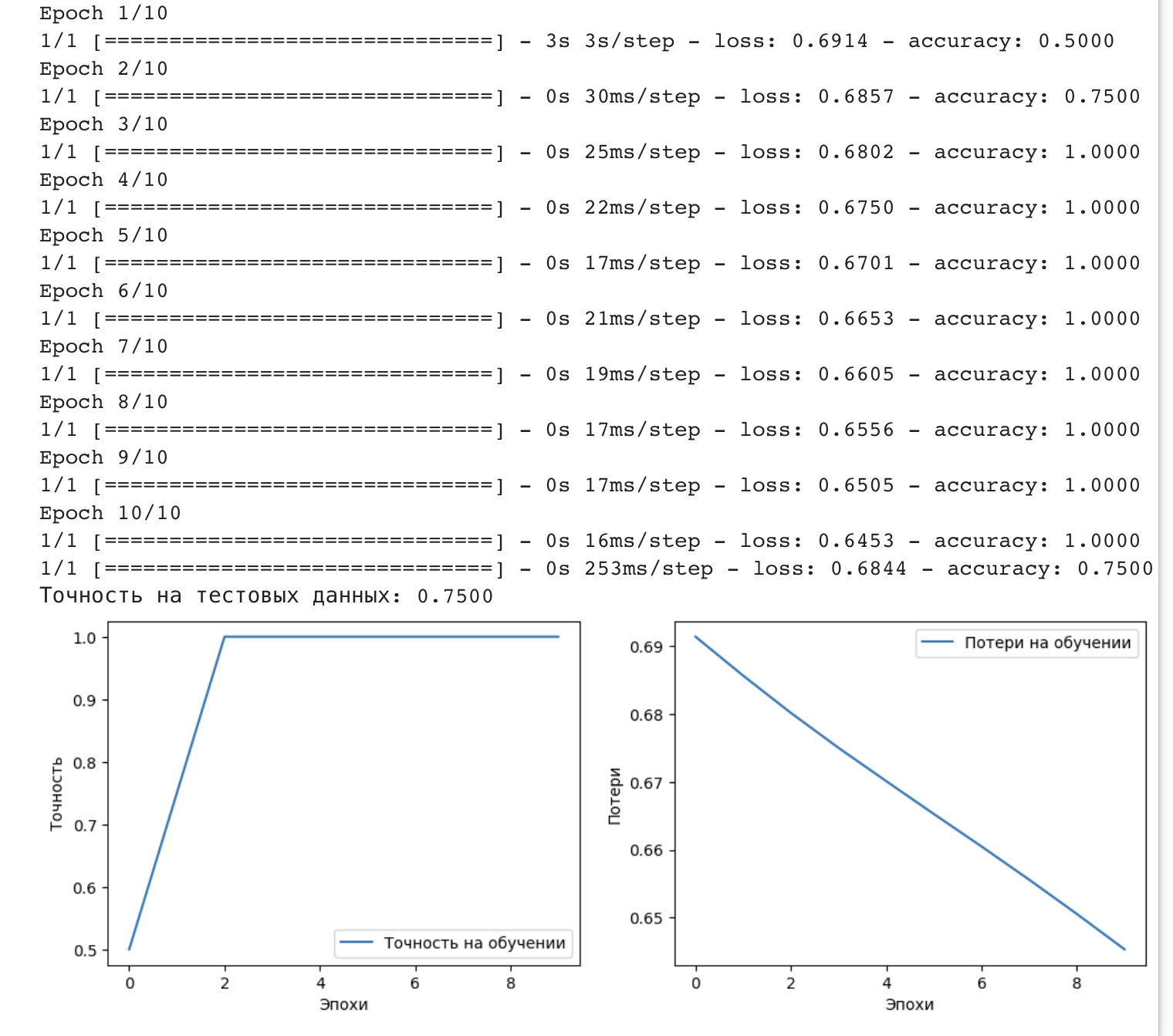

На графиках, полученных после выполнения предоставленного кода, вы увидите результаты обучения и оценку модели. Давайте разберем подробнее:

1. График точности на обучении (Точность на обучении): Этот график показывает, как точность модели изменяется в течение эпох обучения. Точность на обучении измеряет, как хорошо модель предсказывает данные обучения. Вы ожидаете, что точность будет увеличиваться с каждой эпохой. Если точность растет, это может указывать на то, что модель успешно изучает данные.

2. График потерь на обучении (Потери на обучении): Этот график отражает, как уменьшается потеря модели на обучении с течением эпох. Потери представляют собой меру того, насколько сильно предсказания модели отличаются от фактических меток. Цель – минимизировать потери. Уменьшение потерь также указывает на успешное обучение модели.

На практике хорошо обученная модель будет иметь следующие характеристики:

– Точность на обучении растет и стабилизируется на определенном уровне.

– Потери на обучении уменьшаются и стабилизируются на низком уровне.

Если точность на тестовых данных также высока, это означает, что модель успешно обобщает знания на новые, ранее не виденные данные.

На графиках, представленных в коде, вы сможете оценить, как точность и потери меняются с течением эпох, и определить успешность обучения модели.

Кроме того, существуют более сложные архитектуры, которые комбинируют RNN и CNN, чтобы использовать преимущества обоих типов сетей. Например, архитектура под названием Transformer, изначально разработанная для машинного перевода, стала основой для многих современных моделей в NLP, таких как BERT и GPT.

Архитектура Transformer представляет собой мощный прорыв в области обработки естественного языка (NLP) и обработки последовательностей в целом. Она представляет собой нейронную сеть, спроектированную специально для работы с последовательностями, и она имеет ряд ключевых особенностей:

1. Механизм внимания: Одной из ключевых особенностей Transformer является механизм внимания. Внимание позволяет модели фокусироваться на разных частях входных данных в зависимости от их важности. Это улучшает способность модели обрабатывать длинные последовательности и улавливать долгосрочные зависимости в данных.

2. Свёрточные и полносвязные слои: Transformer включает в себя свёрточные слои, которые работают с каждой позицией в последовательности независимо. Это позволяет модели извлекать локальные признаки из текста. Также в архитектуре есть полносвязные слои, которые обрабатывают информацию с учётом взаимодействия всех позиций в последовательности.

3. Многоуровневая структура: Transformer состоит из нескольких идентичных слоев, называемых "трансформерами", каждый из которых обрабатывает входные данные независимо. Это многоуровневое устройство позволяет модели извлекать признаки разной абстракции и работать с последовательностью на разных уровнях.

4. Многоголовое внимание: Transformer также использует многоголовое внимание (multi-head attention), что позволяет модели фокусироваться на разных аспектах входных данных одновременно. Это способствует изучению различных типов зависимостей в данных.

5.Позиционное кодирование: Поскольку Transformer не имеет встроенной информации о позиции слова в последовательности (как у RNN), используется позиционное кодирование. Это позволяет модели учитывать позицию каждого элемента в последовательности.

Архитектура Transformer и её модификации (например, BERT и GPT) стали основой для многих современных задач в NLP, включая машинный перевод, обработку текста, анализ тональности, вопросно-ответные системы и многое другое. Эти модели показали выдающуюся производительность благодаря своей способности к обучению на больших объёмах данных и обобщению на различные задачи.

BERT (Bidirectional Encoder Representations from Transformers) и GPT (Generative Pre-trained Transformer) – это две мощные модели для работы с естественным языком (Natural Language Processing, NLP). Они используют архитектуры Transformer для различных задач NLP, но они имеют разные цели и способы использования. Давайте рассмотрим каждую из них с подробным описанием и примерами использования.

Конец ознакомительного фрагмента.

Текст предоставлен ООО «Литрес».

Прочитайте эту книгу целиком, купив полную легальную версию на Литрес.

Безопасно оплатить книгу можно банковской картой Visa, MasterCard, Maestro, со счета мобильного телефона, с платежного терминала, в салоне МТС или Связной, через PayPal, WebMoney, Яндекс.Деньги, QIWI Кошелек, бонусными картами или другим удобным Вам способом.

Вы ознакомились с фрагментом книги.

Для бесплатного чтения открыта только часть текста.

Приобретайте полный текст книги у нашего партнера:

Всего 10 форматов